亲爱的技术爱好者与行业同仁们,浙大DeepSeek公开课第三期和第四期的精华整理如约而至!在前两期的精彩分享中,我们共同探索了智能时代的趋势与DeepSeek模型的技术优势。此次,谐云特别整理了第三期和第四期的核心内容,带您继续深入AI技术的世界。

公开课01

语言解码双生花:人类经验与AI算法的镜像之旅

报告嘉宾:陈静远

浙江大学教育学院“百人计划”研究员,博士生导师。主要从事教育数据分析与挖掘、多模态教育资源理解与生成等方向的研究工作。主持浙江省领雁科技计划项目、国家自然科学基金青年项目和上海市科技计划项目等;担任国家自然科学基金重大项目、科技部科技创新2030-新一代人工智能重大项目及青年科学家项目子课题负责人。获得浙江省科学技术进步奖一等奖、IETSmartCities最佳论文奖,入选2022年杭州市余杭区十大杰出青年、2022年上海青年科技启明星(A类)等人才项目。以类比揭开语言理解的奥秘,从人类“猜词游戏”到AI“概率迷宫”,展现两者如何通过上下文拼图捕捉语义。人类像玩“成语接龙”一样依赖经验补全信息,而大模型则以万亿参数为“记忆词典”,通过模式匹配生成回答——两者虽路径不同,却形成奇妙的认知镜像。接着深入浅出拆解DeepSeek技术内核:MoE架构如何化身“智能议会”,V3/R1模型怎样完成“学霸进化”,蒸馏技术又如何实现“知识提纯”。最后聚焦教育场景,揭示大模型如何成为教师的“超级外挂”。

01

语言的奥秘:人类如何解码世界

语言造就了人类,人和动物的根本区别就是人具有创造性地运用语言的能力。语言赋予人类秩序。语言是思维的工具,语言是合作的纽带。

如果想要实现通用的人工智能,理解人类使用的不太精确可能有歧义、混乱的语言是一个有效途径。

人类大脑通过理解每个词语的意思、进行词语组装,从而得到句子的意思,甚至推断出句子背后的含义。因此,理解语言的基础是理解词语及词语间的关联关系。人类语言的精准解译与语义歧义的消解具有显著的语境依赖性,需通过系统性整合上下文信息构建语义解析模型。

02

从符号到智能:AI的语言理解之路

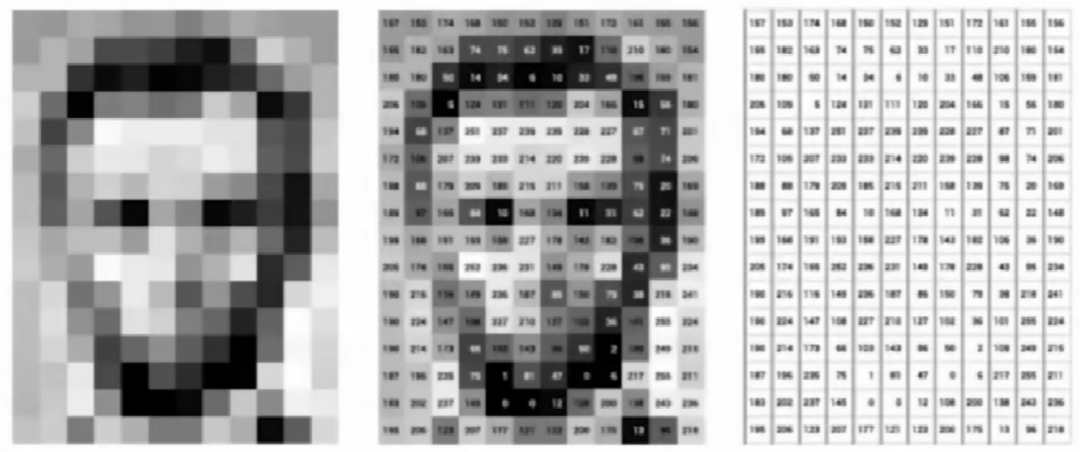

计算机理解一切信息的基础是将信息进行数字化。在处理图像时,计算机会将图像的每一个像素转换为数字信号,通常使用颜色的RGB值来表示每个像素。

那么如何用数字来表示我们(如下图):

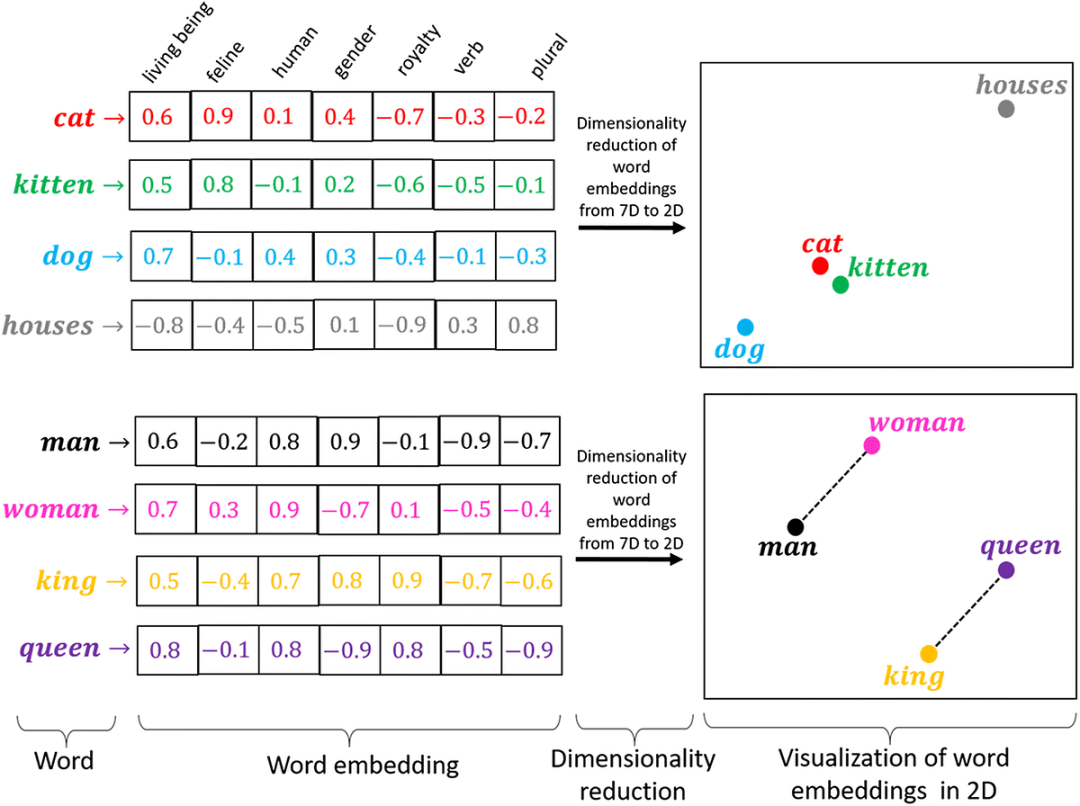

那么,又要如何用数字来表示我们的数字和语言呢?词向量的核心思想是将每一个单词映射到高维的向量空间中,这种以高位向量表示单词的意义就在于可以通过计算向量之间的距离判断词语之间的联系和词义的远近,从而让计算机更好的理解我们的语言。

欧式距离:两个点(或向量)在空间中的“直线距离”。它反映了两个向量的绝对差异。欧氏距离值越小,说明两个向量越接近值越大,说明差异越大。

余弦相似度:两个向量之间夹角的余弦值来衡量它们的相似度它反映了两个向量的方向是否相似,而不关心向量的大小。更适用于比较两者相似性(如文本相似度)。

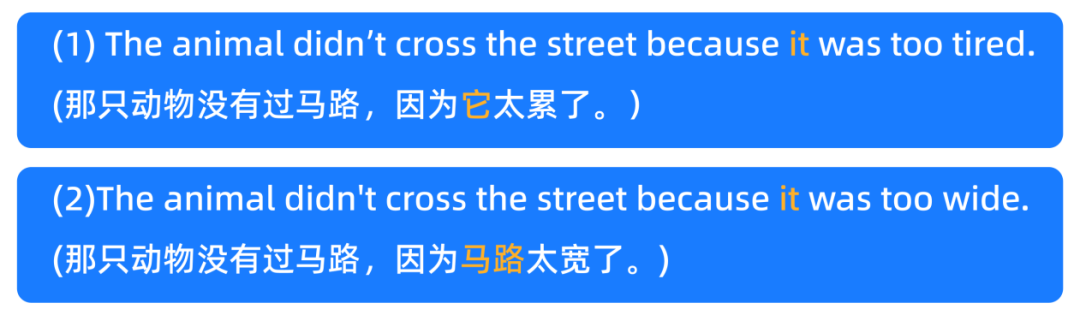

词向量模型存在缺陷。在序列数据中,同一个元素处在不同的上下文中意思是不同的。对于词语的准确理解依赖词语的上下文。例如下面例子中的it由于预警的不同其指代的对象也会存在差异。

大语言模型通过使用Transformer架构,可以为每个词生成一个上下文相关的词向量,这解决了传统词向量无法处理多义词和上下文依赖的问题。一个单词的向量值,需要融合从句子上下文中的其他单词中的信息,在数学上可以表达为所有单词的向量值的加权平均。这些权重值,我们可以称之为注意力权重(attentionweights)。

03

DeepSeek-V3:大语言模型的构建与进化

大语言模型(LLM)最令人印象深刻的能力是它能够通过对话的方式回答用户的问题。那么LLM回答问题的原理是什么呢?

不同于传统问答系统中答案来源于现成的网络或者数据库,大语言模型的回答是随着提问的进行自动生成的。这一点很像文字接龙游戏,大语言模型会基于前面的话不断地生成下一个合成的词汇,直到觉得不必继续生成为止。

数学家陶哲轩:大模型不是魔法,是基于概率的猜测机。

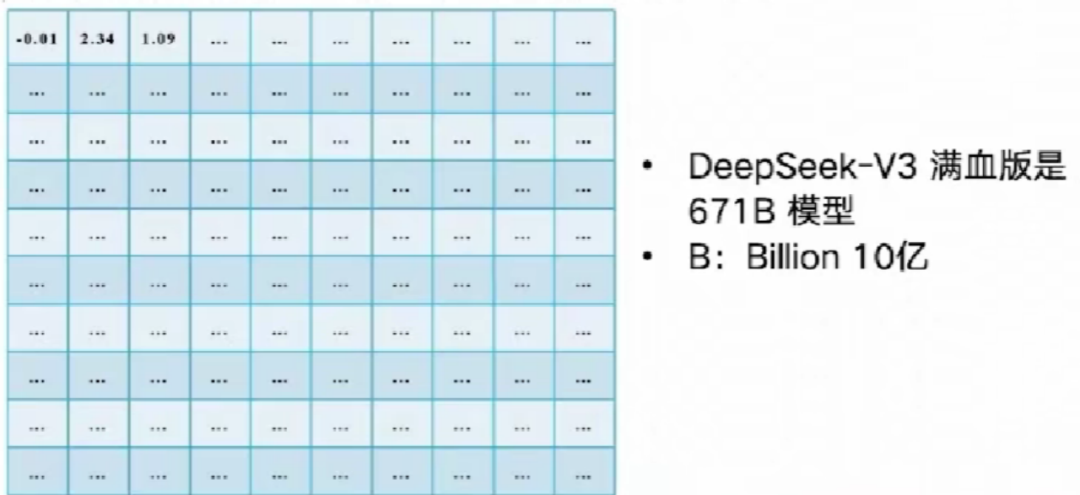

那么大模型是如何不断生成下一个词的概率的呢?实际上,这一过程依赖于模型内部的参数,这些参数通过大量数据的训练来不断调整,蕴含了数据的分布规律,从而使模型能够在特定上下文下预测出最合适的下一个词。并且,当这些参数单元的数量级提升时,系统的认知能力通常会呈现出显著的进化趋势。

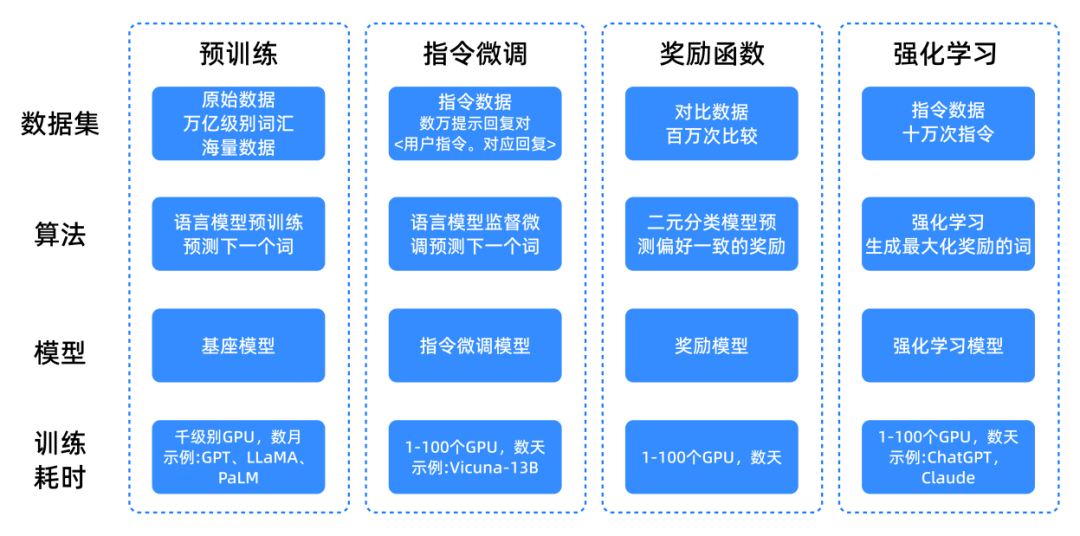

大模型训练流程

1.预训练

在模型预训练(Pretraining)环节,系统通过整合多种来源的数据资源构建训练集,这些数据涵盖互联网网页、维基百科、书籍、GitHub代码库、学术文献及社区问答平台等各类数据源,形成总量达万亿单词级的多样化语料库。

基于超级计算集群(集成数千块高性能GPU)和分布式训练算法,逐步优化深度神经网络的数千亿参数,最终形成具备通用语义理解能力的基座模型(BaseModel)

DeepSeek-V3模型的训练语料库包含14.8万亿词元(Token)。

若让一个人每秒读1个词:需要47万年才能读完,相当于从智人走出非洲开始昼夜不停读到今天。假设每个token是一颗沙粒,14.8万亿颗沙可填满4.5个北京水立方。

2.指令微调

指令微调(InstructionTuning),亦称有监督微调(SupervisedFinetuning),是一种通过向模型提供明确任务指令来实现参数优化的方法。在此过程中,模型不仅学习输入与输出的映射关系更重要的是掌握如何理解并执行各类任务指令。

该阶段的训练数据通常由少量高质量样本构成,这些样本包含用户输入的提示词(prompt)及其对应的理想输出(response)结果,从而确保模型能够准确理解和响应特定任务需求。

3.奖励模型

奖励建模(RewardModeling):构建一个能够评估模型生成内容质量的奖励模型(RewardModel)在强化学习阶段,模型通过与奖励模型的交互,优化其生成策略以最大化奖励。主要采用基于人类反馈的强化学习(RLHF,ReinforcementLearningfromHumanFeedback)方法。模型根据奖励模型的反馈调整参数,从而生成更符合人类偏好的文本。

04

DeepSeek-R1:推理模型的诞生与突破

推理模型是指能够进行复杂推理任务的大型语言模型(LLMS)。这些模型能够处理需要多步推导、计算或分析的问题,通常涉及多个中间步骤。推理模型不仅能够解决基本的推理问题还能应对更复杂的任务,如解谜、数学证明等。

推理模型R1-Zero是怎样炼成的——纯强化学习。

DeepSeek-R1-Zero在强化学习过程中对训练集的平均响应长度。DeepSeek-R1-Zero学会用更多的思考时间来解决推理任务。

公开课02

DeepSeek

走向数字社会:从Deepseek到群体智慧

报告嘉宾:吴超浙江大学长聘副教授,博士生导师,人工智能协同创新中心研究员,计算社会科学研究中心主任,伦敦帝国理工学院计算机系荣誉研究员。研究方向为联邦学习和分布式建模、数据隐私保护和数据定价、计算社会科学等。主持包括国家自然科学基金重点类项目在内的多个科研项目。GalaxyLearning等开源项目的发起者,Mo人工智能教育平台的创始人。吴超教授从人工智能的发展整体趋势观察Deepseek的意义,并深入讨论对社会数字化转型的多方面影响:不仅在社会科学研究中,以Deepseek为代表的大模型是可以提供一种新的研究工具和方法,用更高效、更低门槛的方式实现社会科学数据分析和建模;在社会治理中还能实现类似生成式智能体社会仿真等创新范式,从分布式群体智慧的角度来应对数字社会的深刻变革。

01

人工智能概念的诞生

人工智能并非是一个新兴的概念。它是人类自古以来的梦想和愿景。人类是目前唯一的已知的一种高智慧生物。但是人类一直都希望能够在人之外找到一个和人类具有同样甚至更强智力的对象。我们称之为寻找非人类智能体。从3000多年前古希腊人在陶罐上描绘的第一个“机器人”形象。到后世还有很多神话和科幻小说来描绘这一概念。人们从未停止过畅想和寻找非人类智能体的脚步。

直到计算机的出现,人类才找到一种切实可行的方法去把这种非人类智能体创造出来。有意思的是,计算机一词在诞生之初并非描述一类机器而是一种职业。比如在一战和二战期间,提供人工算力的计算士。到后来计算机演变成为一种通用的计算设备,这起源于计算机公认的鼻祖阿兰图灵,他在其博士论文中提出现代计算机的原型-图灵机。从1937提出图灵机,到1946年计算机被造出来,到今天为止也就七八十年时间。但计算机已经深刻的改变了我们人类的生活。而且图灵在当时认为,我们所处的世界都是由数据和算法构成的,所以计算是实现智能的一个重要道路。

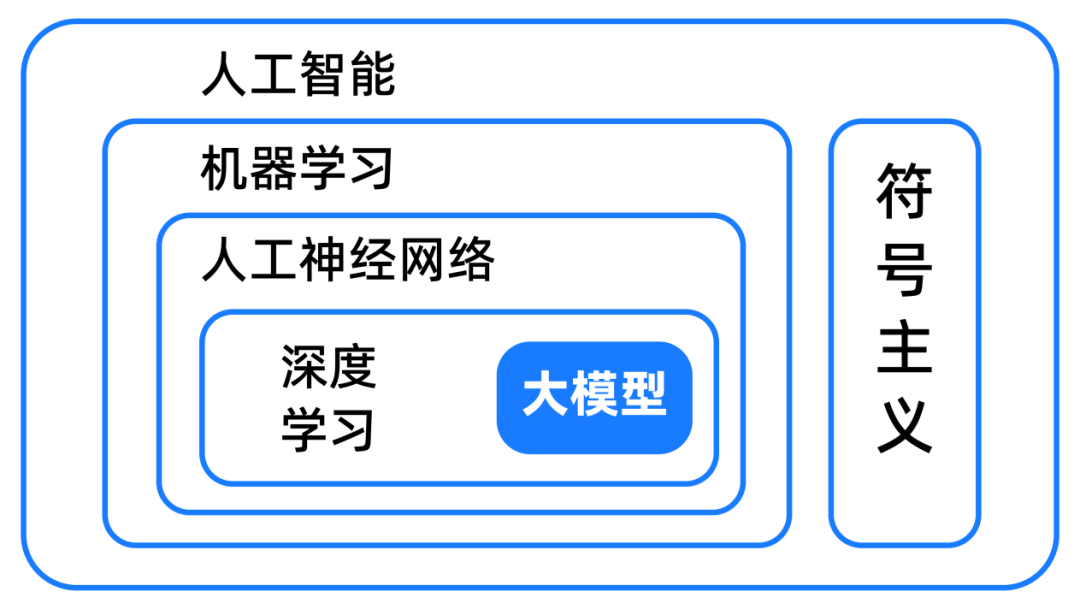

人工智能诞生符号主义,用符号表示,描述知识空间。人类用了10年时间证明了许多公式,符号主义被用来下国际象棋。人工智能遗留专家系统,早期符号主义的成功之处符号主义的成功指出。符号主义的人工智能没法解决很多常见人能解决的问题,例如识别手写体。

02

生成式大模型的发展

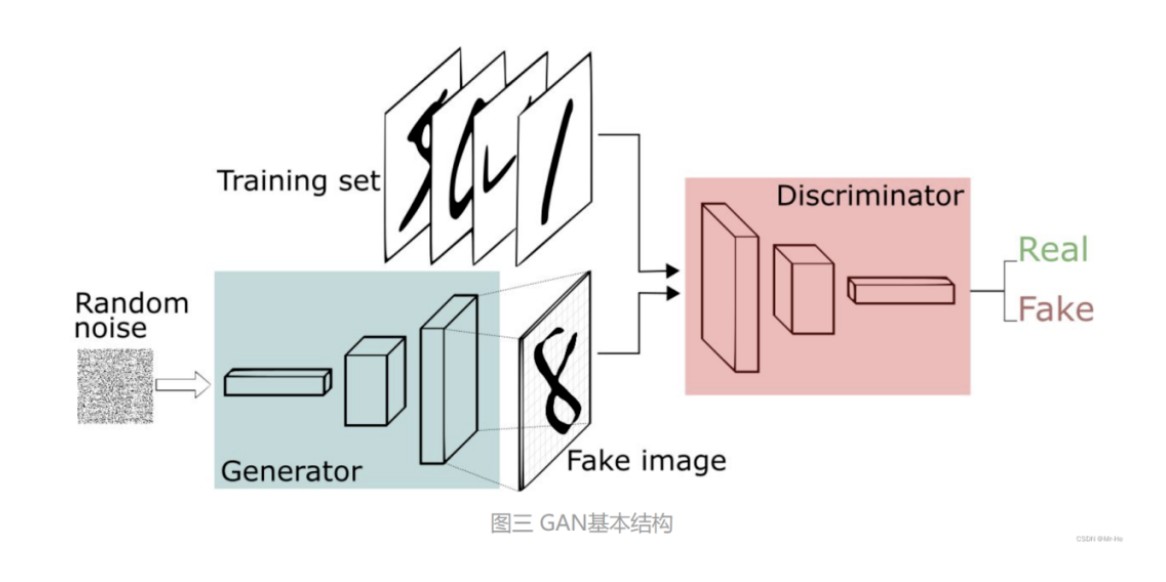

谷歌实习生Goodfellow,后来的OpenAI初创科学家,提出了一个非常有趣的想法。他让生成模型和辨别模型开展对抗,让模型之间互相博弈。博弈的过程其实是一种互相的指导,最终达到模型间的相互指导,就像我们武侠片中常见的左脚踩右脚螺旋上天。

后面我们也出现了许多新的方法。最近这些年出现的扩散模型作为一种先进的生成模型,在过去几年里已经成为了机器学习领域的一个关键进展。DDPM是用于概率数据生成的一种扩散模型,专门用于生成高质量的数据。而如今的生成式大语言模型是规模化的一种体现。它的出现是一种量变到质变的过程。就像构成我们大脑的单元并非十分复杂,但但构成系统的规模和数量级达到一定数量级后就会产生质变从而实现非常复杂的功能。

03

DeepSeek意义

1.挑战大模型的“扩展定律”(RichSutton-TheBitterLesson):在2048块英伟达H800GPU上。

从历史眼光看待,大模型的发展越来越依赖硬件算力的支持是一种发展“逆流”。很少有一种技术是硬件和非人要素影响越来越显著的。

2.训练挑战闭源大模型优于大模型的现状(普及本地部署)。

3.算法改进和工程优化:混合专家模型/多头潜在注意力化学习/蒸馏/思维链/计算优化。

4.激励AI发展更多的浪花!

公开课03

DeepSeek

DeepSeek之火,可以燎原

报告嘉宾:朱朝阳

浙江大学医学院基础医学实验教学中心医学人工智能教学分中心主任,人工智能通识(理工农医)课程组副组长,医工交叉融合人工智能课程负责人,人工智能通识基础(理工农医)教材主编。长期从事机器学习和人工智能的科研教学工作,承担人工智能相关省部级以上课题5项,其他课题10余项,主持浙江大学AI教改类重点项目2项,其他AI教改项目多项。获浙江省科技进步二等奖一项,浙江省中医药科学技术二等奖一项。DeepSeek的迅速走火,引起了全球的广泛关注,其成功的背后究竟隐藏着怎样的原因?中国的人工智能发展正站在新的历史坐标系,未来将如何发展演进?本报告从根植于DeepSeek背后的中华文化基因来探索这些问题的答案。同时,DeepSeek带来的是全民普惠的技术福利,大众如何能应用AI实现个人能力的“二次觉醒”?本报告也将介绍几种无需复杂编程即可使用私有知识库进行本地部署和应用DeepSeek-R1模型的常用方法,并展示一个采用DeepSeek-R1作为基座模型在医学教育中的应用案例。

01

从中华文化基因看DeepSeek成功之道

英文的巴别塔魔咒

英文将成为AI发展的巨大挑战。英语词汇将是一个无底洞,每年都会出现全新的单词例如元宇宙、区块链等。为了学习这些单词,训练成本将会与日俱增。每年为了学习这些新增的词汇就不得不采用增大模型参数来解决。

如果按照现在的语言词量发展2050年就需要消耗1.7个地球的算力。同时英文存储的低效和空间浪费,例如cattle牛+meat肉=beaf牛肉。每个单词都是独立个体不存在相互联系。

汉语的高效和可传承

汉字起源于上古的象形文字,历经甲骨文、金文、小篆、隶书、楷书、简化字等演变一路传承,蕴含着中华文明的核心基因密码。汉字每年的增量几乎为0。汉字通过构词法搭积木形式,达到知识迁移。例如肉+猪=猪肉,字与含义之间存在联系。

02

DeepSeek与ChatGPT训练语料对比

1.ChatGPT

英文语料占比约92.6%,主要来源于互联网公开文本,包括维基百科、新闻报道、书籍、学术论文、程序代码等。

中文语料占比仅约0.1%,来源单一,学术文献不足,中文互联网内容(如社交媒体、论坛)噪声较多,需复杂清洗。

2. DeepSeek

总语料规模:14.8万亿token,涵盖多语言、数学、编程等领域,其中87%代码、10%英文、3%中文。

3. 中文语料特点

有约2.3亿字精校的古典文献;覆盖网络文学、社交媒体、学术论文等现代文本;通过“千字文”式分词算法增强对成语、典故理解。

4. 数据处理技术

l 过滤机制:采用多层净化技术(如“八面受敌法”),数据噪音剔除精度达99.7%

l 分词优化:结合古典语法与现代汉语的分词算法,使成语理解准确率提升38%。

l 长上下文支持:通过两阶段扩展训练,将上下文窗口扩展至128K,增强长文本处理能力。

03

DeepSeek的二点争议

争议一:知识蒸馏是抄袭还是创新

知识蒸馏(KnowledgeDistilation)是一种模型压缩和加速技术,旨在将大型模型(教师模型)的知识迁移到小型模型(学生模型),在减少计算资源消耗,缩短推理时间的同时,尽可能达到接近大型模型的性能。

DeepSeek通过对技术的整合,用巧妙的方式用ChatGPT不到二十分之一的算力,就训练出了媲美ChatGPT的模型,这是一种技术和工艺上的创新。

争议二:人工智能是资源黑洞还是效率革命

随着大模型参数规模不断变大,训练所需的算力也越来越高。比如Grok3使用了10万块的H100的卡进行训练并且目前已经扩展到20万张卡。大模型正在不断的吞噬着地球的资源。AI的发展初心本是要提高我们的效率。我们应该更加关注人工智能如何与地球现有资源达成平衡。DeepSeek仅用200张卡就能完成训练,这是人工智能和资源消耗关系上的一次革新。

04

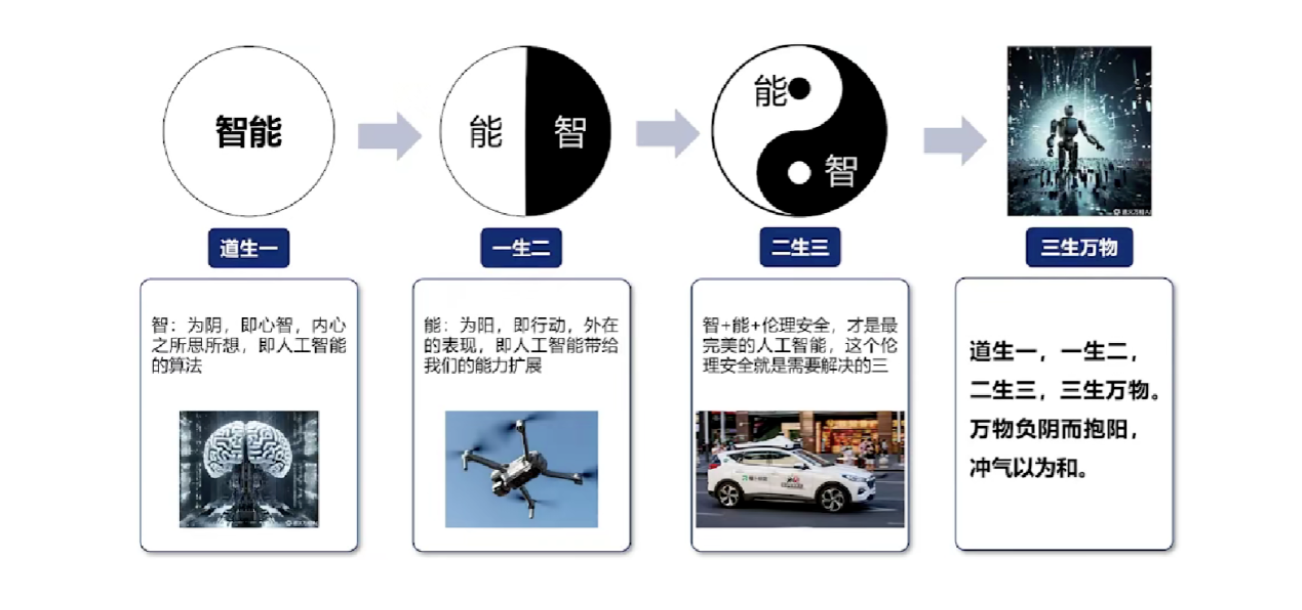

关于人工智能未来发展之路的思考

堆量不堆质的发展之路难道是AI的发展方吗?

道是规律、道理和本源,而术则是指具体的方法和技巧。这句话告诉我们在解决问题时,只有掌握了事物发展的规律,才能更好地寻求技巧和方法,而只有真正理解和掌握了“道”和“术”,才能更好地应对各种问题,举一反三,不断取得成功。

05

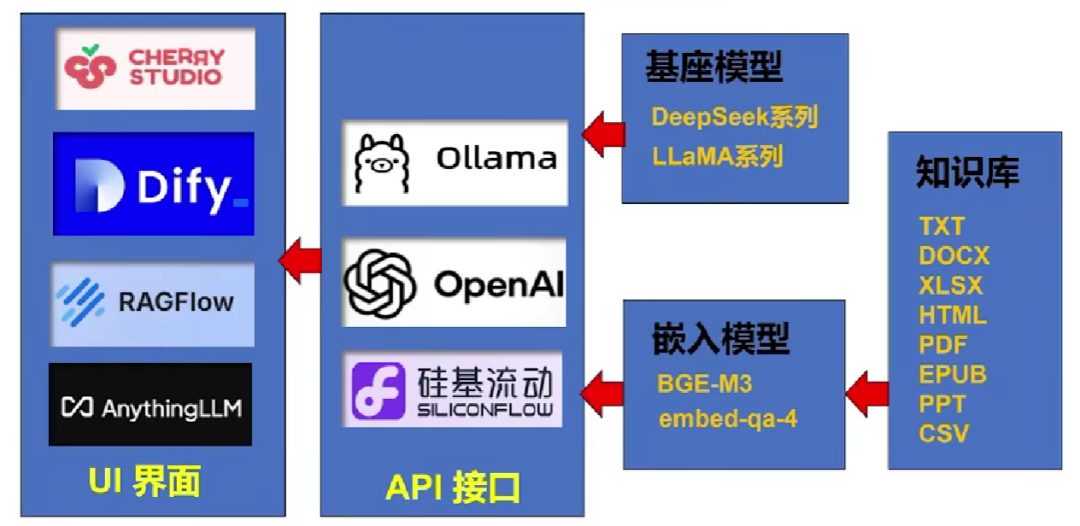

DeepSeek私有化应用方法

公开课04

DeepSeek的本地化部署与AI通识教育之未来

报告嘉宾:陈建海

浙江大学计算机学院博导/副教授,基础教学中心副主任兼党支部书记,浙江大学人工智能教育教学研究中心《人工智能基础(理工农医)》通识课程团队负责人、浙江大学智能计算&系统实验室(Incas-lab)、超算竞赛基地负责人,CCF区块链专业委员会执行委员。发表CCFA等高水平会议期刊论文超过30余篇,获授权发明专利40余项及软著4项,参编标准1项。陈建海教授主要介绍了DeepSeekAI的时代背景、本地化部署及对未来教育影响等内容,也将介绍浙江大学AI通识教育改革进展等。

01

DeepSeek的本地化部署

什么是DeepSeek的本地化部署

Deepseek的本地化部署是指将人工智能系统(如模型、算法及服务)部署在用户指定的本地服务器或基础设施中,而非依赖云端服务,旨在实现数据主权掌控、文化适配优化和合规性保障的技术方案。其核心是通过技术与场景的深度结合,满足特定区域、行业或机构的个性化需求。

DeepSeek的本地化部署优势

DeepSeek的部署

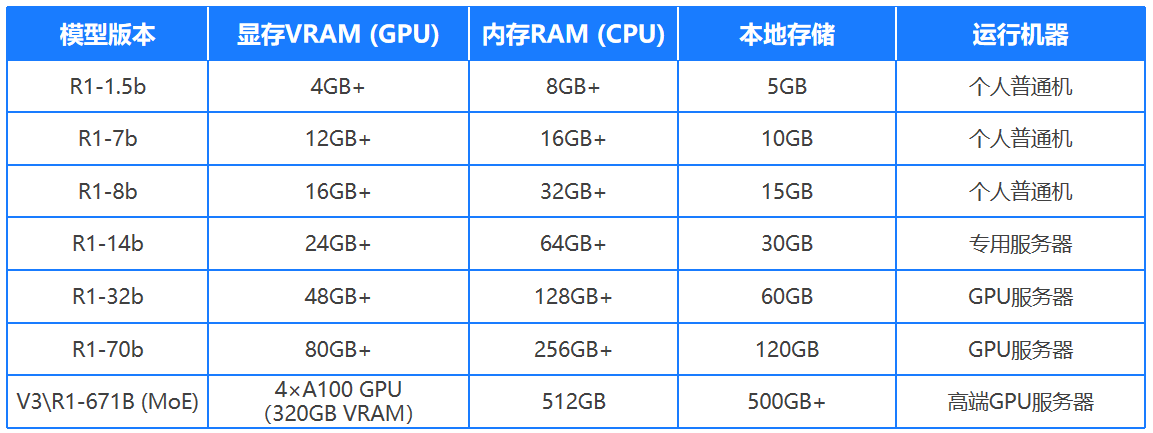

Deepseek系列模型包括V3(671b)、R1(660b)和基于DeepSeek-R1蒸馏的模型,如下表。

教育和科学领域任务需求,包括智能问答系统、学习辅助工具、数据分析助手、论文摘要生成等任务,可以基于deepseek搭建和部署本地的小模型环境。

DeepSeekR1蒸馏版均可进行本地化部署。

小规模的1.5b-8b的可部署在普通机,其余需要GPU。

全量版MoE671b:无法直接本地部署,但有压缩的动态量化版本实现本地化,需高端GPU服务器。

DeepSeek本地版-基于PageAssistforOllama(网页版)

PageAssist是浏览器插件,基于本地AI模型的WebUI工具,可视化的模型对话,提供便捷的交互界面支持视觉模型和文档交流功能

PageAssistfor0llama官网入口网址:https://openi.cn/sites/143085.html

下载插件:https://www.chajianxw.com/product-tool/85997.html

浙大DeepSeek公开课第三期和第四期,从大模型的应用实践到AI工程化的关键技术,为我们展现了AI技术从理论到落地的完整路径。谐云希望通过整理与分享这些精彩内容,帮助更多企业与技术爱好者把握AI2.0时代的机遇,实现技术与业务的深度融合。